L'Institut Polytechnique de Paris attribue ses prix de thèses 2025

Neuf doctorants se sont illustrés pour cette édition 2025. Deux d'entre eux (ex-aequo) ont reçus le grand prix de thèse IP Paris doté de 5000 €, et sept se sont illustrés dans la catégorie meilleure thèse de département d'enseignement et de recherche et reçoivent un prix de 3000 €.

Les lauréats 2025

IP PARIS BEST THESIS AWARDS

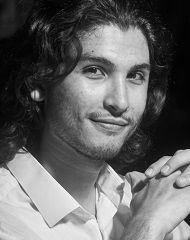

Souhaib Attaiki, Département d'Informatique, de Données et d'IA, issu du Laboratoire d'Informatique de l’École polytechnique (LIX).

Grâce à sa thèse, Souhaib Attaiki a levé un verrou majeur de l’analyse automatique des formes 3D : celui de la correspondance automatique entre formes dites non rigides — c’est-à-dire les formes pouvant se plier, s’étirer ou se déformer.

C’est un verrou majeur de l’analyse automatique des formes 3D que Souhaib Attaiki a levé lors de sa thèse au Laboratoire d’Informatique de l’École polytechnique (LIX*) : celui de la correspondance automatique entre formes dites non rigides — c’est-à-dire les formes pouvant se plier, s’étirer ou se déformer. Entre mathématiques, informatique et intelligence artificielle, le jeune chercheur a développé de nouvelles méthodes pour faire correspondre des objets tridimensionnels complexes (corps humains, structures biologiques) même lorsqu’ils sont partiellement observés ou différemment déformés. Les applications sont nombreuses : en imagerie médicale pour comparer des organes ; en animation 3D, pour transférer des mouvements d’un personnage à un autre ; et en réalité virtuelle.

« Établir une correspondance, c’est retrouver quel point d’une forme correspond à quel point d’une autre », explique le jeune docteur qui a reçu le grand prix de thèse 2025 de l’Institut Polytechnique de Paris. « Facile à dire, mais plus difficile à faire lorsque les formes sont complexes, incomplètes ou fortement distordues ».

Pour relever ce défi, Souhaib Attaiki a conçu de nouvelles architectures de deep learning capables d’apprendre ces correspondances sans intervention humaine, y compris en l’absence de données annotées. Il a ainsi proposé un modèle permettant de mieux faire dialoguer les deux formes analysées (Deep Partial Functional Maps), qu’elles soient complètes ou non, et a introduit une méthode originale qui apprend à retrouver des correspondances cohérentes, même sans exemples préalables ou lorsque les formes sont très différentes (Neural Correspondence Prior).

Parallèlement, le jeune chercheur a démontré comment améliorer les représentations internes utilisées par les réseaux de neurones pour les rendre plus générales, réutilisables d’une tâche à l’autre, et robustes face à des variations importantes. Il a également conçu une méthode zero-shot, c’est-à-dire capable d’établir des correspondances sans entraînement préalable sur un jeu de données.

Ces contributions théoriques et pratiques ouvrent la voie à de nouveaux usages dans l’analyse des formes 3D, notamment dans des contextes où les données sont rares ou bruitées. Elles intéressent déjà plusieurs équipes de recherche et secteurs industriels. « Par exemple, en médecine, elles pourraient aider à détecter des malformations crâniennes en comparant un crâne d’enfant avec une forme de référence. Dans le domaine de l’animation, elles permettent de transférer les mouvements d’un seul personnage vers d’autres, réduisant ainsi les coûts de production ».

Aujourd’hui, Souhaib Attaiki poursuit ses travaux dans la recherche privée, en appliquant les techniques d’IA à la génération d’images. Le grand prix de thèse IP Paris représente à ses yeux une reconnaissance importante, qui, espère-t-il, lui ouvrira aussi les portes de la recherche académique et de l’enseignement.

>> La thèse de Souhaib Attaiki

*LIX: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

Clément Le Ludec, Département des Sciences Sociales et Management, issu du Laboratoire i3 SES de Télécom Paris.

En 2017, deux économistes prédisaient que 50 % des métiers seraient foncièrement modifiés voire remplacés par l’IA. Dans ce climat d’inquiétude lié à la fin du travail, et pour évaluer l’impact réel de l’IA, Clément Le Ludec s'est attelé à la compréhension des procédés de fabrication des modèles et leur utilisation par les organisations (entreprises, services publics…).

En 2017, deux économistes (Carl Benedikt Frey et Michael Osborne) prédisaient que 50 % des métiers seraient foncièrement modifiés voire remplacés par l’IA. « Ils pointaient en réalité des tâches remplaçables par cette technologie, pour plusieurs professions. Or, dans ce climat d’inquiétude lié à la fin du travail, et pour évaluer l’impact réel de l’IA, il est nécessaire de comprendre les procédés de fabrication des modèles et leur utilisation par les organisations (entreprises, services publics…) », explique Clément Le Ludec, issu du laboratoire I3* de Télécom Paris, lauréat du grand prix de thèse 2025 de l’Institut Polytechnique de Paris.

Le jeune chercheur a mis en évidence une nouvelle répartition du travail induite par le fonctionnement des systèmes d’IA, au sein de startups françaises productrices de données d’entrainement de ces modèles. Celles-ci font appel à des sous-traitants localisés à Madagascar pour annoter leurs bases de données (constituées d’images notamment). Cette organisation s’oppose à une plateforme mise en place par Amazon dans les années 2010 qui, via le principe du micro-travail rémunéré à la tâche, permettait à quiconque de labéliser des données pour le compte d’entreprises, de chercheurs, etc. « Un autre fonctionnement est donc possible, dans lequel les travailleurs de la donnée acquièrent une expertise et développent le contact client. L’ensemble est bénéfique pour le sous-traitant, la startup et les systèmes d’IA qu’ils contribuent à construire ».

En effet, l’heure n’est plus à créer des modèles d’IA uniquement dédiées à la recherche, mais aussi utilisables au quotidien et requérant une labélisation toujours plus complexe. Clément Le Ludec a ainsi montré que les travailleurs de la donnée se dotent d’une forte capacité perceptuelle et alertent les développeurs d’IA sur des dysfonctionnements qui leur auraient échappé. Ces qualités sont reconnues par les startups qui se dirigent naturellement vers des pays linguistiquement et culturellement proches - souvent dans un contexte post-colonial - pour faciliter les échanges conceptuels et normatifs autour du développement des modèles d’IA. Le tout en maintenant des coûts réduits. « Malheureusement, les conditions de travail et salariales restent insuffisantes, y compris dans le contexte malgache. Cette reconnaissance des compétences nécessaires à l'annotation est donc indispensable à l’amélioration des modèles d'IA et du devenir des travailleurs des données ».

Par ailleurs, le jeune docteur a étudié l’impact de cette répartition du travail de labélisation sur les biais des modèles d’IA. De l’édiction des règles d’annotation à leur application, il apparait que toute décision humaine appliquée à un système d’IA génère des biais qui se répercutent sur l’ensemble de la chaine de production du modèle. « L’humain aura toujours sa place dans la conception de ces systèmes. Difficile de savoir jusqu’où agir pour stopper le phénomène ».

La thèse de Clément Le Ludec relève de la recherche fondamentale. Elle trouve cependant un écho auprès d’entreprises du secteur qui souhaitent améliorer leur organisation du travail, notamment au regard de l’AI Act de l’Union européenne, exigeant des jeux de données simplifiés, l’amélioration des conditions de travail des professionnels de la donnée, etc.

>> La thèse de Clément Le Ludec

*Institut Interdisciplinaire de l'innovation (i3) : CNRS, École polytechnique, Mines Paris-PSL, Télécom Paris, Institut Polytechnique de Paris, 91120 Palaiseau, France

DEPARTMENT BEST PHD THESIS AWARD

Raphaela Andres, Département d'Économie, issue du Centre de Recherche en Economie Statistique (CREST)/ Laboratoire i3 SES (Télécom Paris).

Comment améliorer la société et l’économie en réduisant les risques liés au numérique ? Pour répondre à la question, Raphaela Andres a mené une étude empirique sur les interventions politiques et managériales dans l'économie numérique. Elle a ensuite analysé leur efficacité et leurs potentiels effets secondaires.

Comment améliorer la société et l’économie en réduisant les risques liés au numérique ? Raphaela Andres, lauréate du prix de thèse 2025 du Département d’Économie de l’Institut Polytechnique de Paris s’est emparée de la question. Issue du CREST* à Télécom Paris, elle a mené une étude empirique sur les interventions politiques et managériales dans l'économie numérique. Elle a ensuite analysé leur efficacité et leurs potentiels effets secondaires.

Le premier travail de Raphaela Andres a consisté à étudier les effets de la politique d’aide publique aux entreprises en vigueur dans les régions allemandes économiquement en retard. Celle-ci accorde une aide financière aux entreprises souhaitant acquérir, par exemple, du matériel informatique. Les coûts d’investissements étant réduits, les plus jeunes orientent leurs dépenses en ce sens, au détriment d’achats de logiciels qui leurs sont pourtant bien souvent préférables. « C’est un frein pour le développement de ces entreprises. L’aide n’est donc plus optimale, ni pour elles, ni pour l’économie. Il devient nécessaire d’évaluer cette politique publique désormais dépassée et de la mettre régulièrement à jour, notamment au vu de la rapidité des changements sociétaux et technologiques ».

Les médias sociaux, et plus particulièrement la communauté germanophone sur X, étaient également dans le scope de Raphaela Andres. Elle y a évalué la prévalence des propos haineux après l’adoption d’une loi (Network Enforcement Act) réattribuant aux plateformes la responsabilité des paroles tenues ou laissées visibles. « Le discours haineux persiste sur X où ses auteurs sont toujours présents mais plus modérés. Mais celui-ci se déplace vers des plateformes plus modestes ». En raison de leur petite taille et des coûts élevés liés à la modération, la loi exclut délibérément ces dernières. Les mots sont là, virulents, mais leur portée reste faible du fait de l’envergure réduite des communautés. « Le texte a donc un impact ». L’étude offre par ailleurs un aperçu des potentiels effets du Digital Service Act instauré par l'Union Européenne.

La jeune scientifique a complété son travail en analysant l’impact des régulations sur l’économie créative. En 2017, de nombreuses marques ont quitté YouTube afin de ne pas être associées aux contenus hostiles hébergés sur la plateforme. Cet « Adpocalypse » a poussé le célèbre réseau à durcir sa politique de modération. Les créateurs publiant des contenus simultanément sur plusieurs plateformes (multihoming) se sont adaptés en investissant davantage les autres sites. « Une plateforme comme Patreon concentre plus de commentaires, d’adhésions, d’appréciations mais peu de toxicité après l’intervention de YouTube».

Raphaela Andres adresse son travail aux décideurs publics et aux managers de l’économie numérique. Elle souligne que dans ce domaine, il est plus que jamais nécessaire de prendre en compte l’ensemble des parties prenantes et la rapidité de l’évolution technologique.

>> La thèse de Raphaela Andres

*CREST : une unité mixte de recherche CNRS, École polytechnique, GENES, ENSAE Paris, Institut Polytechnique de Paris, 91120 Palaiseau, France

Rafaela Bechara, Département de Chimie et Procédés, issue du Laboratoire de Physique de la Matière Condensée (PMC) à l’École polytechnique.

En chimie, pour transformer un produit A en B via une réaction, il faut parfois un petit coup de pouce - la catalyse - à l’aide d’une molécule spécifique - le catalyseur. Au cours de sa thèse, Rafaela Bechara a travaillé sur des procédés permettant de simplifier la catalyse et d'améliorer l'efficacité des réactions en jeu, le tout dans une optique de chimie verte.

Rafaela Bechara est tombée dans la catalyse lors de son Bachelor au Brésil et ne l’a plus quittée en intégrant le PHD Track de l’Institut Polytechnique de Paris. « En chimie, pour transformer un produit A en B via une réaction, il faut parfois un petit coup de pouce - la catalyse - à l’aide d’une molécule spécifique - le catalyseur », explique la jeune chercheuse, lauréate du prix de thèse du Département de Chimie de l’Institut Polytechnique de Paris, issue du Laboratoire de Physique de la Matière Condensée de l'École polytechnique (PMC*). « Le procédé est couramment utilisé dans l’industrie car il permet de gagner du temps réactionnel. C’est aussi un des grands concepts de la chimie verte qui cherche à utiliser moins de ressources et à rejeter moins de polluants ».

Toutefois, lorsque le catalyseur est présent dans le même milieu que les autres réactifs (catalyse homogène), celui-ci doit être isolé du produit obtenu à l’aide de purifications souvent longues et coûteuses. « Au cours de ma thèse, je suis parvenue à fixer des catalyseurs sur des supports solides en silicium (comme ceux utilisés pour le photovoltaïque), ce qui permet de les séparer des produits par simple filtration », s’enthousiasme Rafaela Bechara. Particularité du procédé, les molécules sont en réalité intégrées à des chaines de polymères que la scientifique fait croitre sur ces supports. « Il y a ainsi davantage de catalyseurs par unité de surface de silicium et l’efficacité de la réaction augmente ».

Pour ce faire, la chimiste a mis au point un procédé de greffage par microondes qui fixe l’amorceur de la polymérisation au support de silicium. Elle a ensuite utilisé des complexes de Salen – des molécules organiques comportant un métal – comme catalyseurs. « Ils sont multitâches et vraiment avantageux car il suffit de changer de métal pour catalyser d’autres réactions ». Rafaela Bechara a appliqué cette technique à des siliciums macroporeux avec l’idée que les pores offrent plus de surface d’accrochage aux polymères et donc davantage de catalyseurs par unité de surface. « Les expérimentations ont montré qu’il fallait utiliser des nanoparticules de silicium poreux pour avoir assez de surface utile et effectuer les tests de catalyse. Ce sera la prochaine étape de ces travaux ». Parallèlement, la jeune docteure a développé une technique utilisant uniquement l’ensemble polymère-catalyseur. Celui-ci peut alors être récupéré par simple précipitation et réutilisé jusqu’à 7 fois tout en conservant son pouvoir réactif. Une véritable économie d’atomes !

Aujourd’hui diplômée, Rafaela Bechara a intégré le Collège de France où elle travaille sur les catalyseurs homogènes et les réactions photocatalytiques. « Je continue à jouer avec la chimie et à l’explorer pour qu’elle soit toujours plus intéressante et plus verte ».

>> La thèse de Rafaela Bechara

*PMC: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

Alice Boillet, Département de Mécanique et d'Énergétique, issue du Laboratoire d'Hydrodynamique de l'École polytechnique (LadHyX).

La travail d'Alice Boillet s'inscrit à l'interface de la mécanique, de la modélisation et de la physiologie. Au cours de son doctorat, elle a mis au point des jumeaux numériques d'athlètes et des modèles mécaniques pour déterminer des stratégies de gestion optimale de l'effort en cyclisme sur piste et en aviron, en vue des JO de Paris.

Au premier abord, le cyclisme et l’aviron sont deux sports que tout oppose…sauf pour Alice Boillet, lauréate du prix de thèse du Département Ingénierie, Mécanique et Énergie de l’Institut Polytechnique de Paris et ancienne doctorante du LadHyx*. « Sur le plan mécanique, les deux disciplines proposent des courses avec un mouvement cyclique. Physiologiquement, dans les deux cas il existe des courses/épreuves de demi-fond mobilisant les mêmes filières énergétiques », souligne la jeune docteure. C’est donc à l’interface de la mécanique, de la modélisation et de la physiologie qu’a pris vie la thèse d’Alice Boillet.

« J’ai débuté mon doctorat 3 ans tout pile avant les Jeux Olympiques de Paris, dans le cadre du programme Sciences 2024. Le timing était parfait et les travaux s’annonçaient passionnants ». Alice Boillet avait pour mission de répondre aux questions des entraineurs des fédérations en déterminant les stratégies de gestion optimale de l’effort.

Côté cyclisme, la jeune docteure s’est intéressée à la poursuite par équipe sur piste. Il s’agissait de déterminer les relais optimaux selon les caractéristiques physiologiques des athlètes. « J’ai développé pour cela un modèle de jumeau numérique des athlètes qu’il suffit de paramétriser avec leurs mesures physiologiques habituelles, comme la VO2 max (ndlr : la VO2 max correspond à la consommation maximale d’oxygène d’un athlète par unité de temps et à la capacité « aérobie** » maximale). Le modèle prédit également, de manière non invasive, le taux de lactate musculaire des sportifs (ndlr : l’accumulation de lactate est associée à la capacité « anaérobie*** » maximale). On peut alors leur faire courir virtuellement une course et anticiper l’impact de celle-ci sur leur fatigue et leur état physiologique ». Parallèlement, Alice Boillet a utilisé un modèle mécanique prédisant la vitesse des coureurs à partir de la puissance qu’ils génèrent. En connaissant la distance du parcours, il est possible de déduire un temps théorique d’arrivée. Dès lors, différentes stratégies de course peuvent être testées et optimisées à l’aide de ces deux modèles couplés.

« Mes travaux ont par ailleurs fortement intéressé la fédération d’aviron lorsque la distance de course aux prochains JO de Los Angeles a été raccourcie à 1500 mètres au lieu de 2000 mètres ». L’annonce a en effet soulevé de nombreuses questions : faut-il partir avec la même vitesse, modifier l’entraînement des athlètes, etc. ?

Alice Boillet a transmis son modèle aux fédérations sportives et travaille aujourd’hui pour un équipementier orthopédique en tant qu’ingénieur R&D. « Le prix de thèse IP Paris reste toutefois une reconnaissance de mon travail et de ma légitimité dans un milieu qui m’était inconnu et dans lequel il a fallu que je m’affirme en tant que femme. C’est un honneur pour moi de l’avoir reçu ».

* LadHyX: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

** La filière énergétique aérobie permet les efforts d’endurance d’une durée prolongée de quelques minutes à quelques heures comme la réalisation d’un marathon.

***La filière énergétique anaérobie permet la mise en route brutale d’un groupe musculaire pour réaliser un geste ou un effort intensif et bref.

Abdelaziz Bounhar, Département d'Information, de Communication et d'Électronique, issu du Laboratoire Traitement et Communication de l'Information (LTCI) à Télécom Paris.

Comment permettre à des objets connectés de transmettre des données efficacement et sans être repérés ? C’est le sujet de la thèse d’Abdelaziz Bounhar, dédiée à l’apprentissage par renforcement et la communication furtive pour l’internet des objets (IoT).

Comment permettre à des objets connectés de transmettre des données efficacement et sans être repérés ? C’est le sujet de la thèse d’Abdelaziz Bounhar, ancien doctorant du LTCI* de Télécom Paris, dédiée à l’apprentissage par renforcement et la communication furtive pour l’internet des objets (IoT). Ce travail de recherche fondamentale lui a valu le prix de thèse 2025 du Département Information, Communications, Électronique de l’Institut Polytechnique de Paris.

Si la cryptographie sécurise la transmission de l’information via une clef de cryptage, elle est énergivore et rend détectable les échanges de données. La communication furtive elle, consomme très peu d’énergie, est non détectable mais aussi sécurisable via une clef de cryptage. Elle est donc parfaitement adaptée à l’IoT : dans le domaine de la santé par exemple, où des données confidentielles et personnelles transitent entre appareils, mais aussi dans le secteur industriel, où les économies d’énergie sont nécessaires pour des objets évoluant en autonomie pendant de longues périodes.

Dans ce contexte, Abdelaziz Bounhar s’est intéressé aux limites fondamentales de la communication furtive et à l’optimisation d’un réseau d’utilisateurs par l’intelligence artificielle (IA). Il a, dans un premier temps, caractérisé mathématiquement le lien entre le débit maximal qu’un utilisateur furtif peut atteindre et la taille de la clef servant à chiffrer ses messages. « J’ai montré comment adapter dynamiquement le débit de communication en fonction de la clef disponible, quelle que soit sa taille. Cet enjeu est crucial car la génération des clefs est coûteuse en temps et en ressources. Pourtant, il était resté sans solution jusqu’ici ».

Le jeune chercheur a par ailleurs découvert un phénomène inédit : au-delà de deux utilisateurs sur un réseau, la communication furtive autorise la transmission de données à débit maximale simultanément. « Aucun utilisateur n’a besoin de réduire son débit pour les autres, donc aucun compromis (trade off) n’est nécessaire entre eux ».

Par la suite, Abdelaziz Bounhar s’est intéressé à des configurations plus réalistes et plus complexes, où coexistent utilisateurs furtifs et non furtifs. Il a non seulement caractérisé les limites fondamentales de ces systèmes hybrides, mais aussi conçu des algorithmes se basant sur l’apprentissage par renforcement pour optimiser les réseaux de communications. En effet, dans une configuration mêlant communication furtive et non furtive, les débits requis diffèrent et il est indispensable de prioriser les transmissions de données. « L’IA, et notamment l’apprentissage par renforcement, aide à apprendre une politique optimale de communication en tenant compte des données, de la qualité du canal, de l’énergie nécessaire, etc. ».

Aujourd’hui l'IA est également utilisée dans un autre contexte pour compresser intelligemment l’information à transmettre. Elle permet de se concentrer sur le cœur de l’information, celle indispensable à l’exécution d’une action. « C’est la sémantique de l’information. Imaginons que l’IA d’un système domotique ait besoin de reconnaitre un chat pour déverrouiller une chatière. Inutile de lui transmettre une image complète, mais lourde de chat. Quelques caractéristiques (features) clés du félin suffisent ». Abdelaziz Bounhar a ainsi défini les limites fondamentales de la communication sémantique dans un cadre furtif.

Si les travaux d’Abdelaziz Bounhar restent théoriques, ce prix de thèse témoigne de leur fort potentiel. Aujourd’hui AI Research Engineer au sein d’une université Émirati (MBZUAI), il consacre son temps à l’apprentissage par renforcement pour la fiabilité (alignement) et à la sécurisation de l’IA, tout en contribuant à l’entraînement de grand modèles de langage (LLM) toujours plus performants.

>> La thèse d'Abdelaziz Bounhar

*LTCI : un laboratoire de recherche Télécom Paris, Institut Polytechnique de Paris, 91120 Palaiseau, France

Baptiste Goujaud, Département de Mathématiques, issu du Centre de Mathématiques Appliquée de l’École polytechnique.

Machine Learning, réseaux de neurones, deep Learning…Tout repose sur des algorithmes d’apprentissage qu’il est nécessaire d’optimiser pour en améliorer les prédictions. Baptiste Goujaud a effectué un travail de recherche fondamentale et théorique pour analyser ces algorithmes et fournir à la communauté scientifique une boite à outils facilitant leur utilisation.

Machine Learning, réseaux de neurones, deep Learning…Tout repose sur des algorithmes d’apprentissage qu’il est nécessaire d’optimiser pour en améliorer les prédictions. Au cours de sa thèse - pour laquelle il a reçu le prix de thèse 2025 du Département de Mathématiques de l'Institut Polytechnique de Paris - Baptiste Goujaud a effectué un travail de recherche fondamentale et théorique pour analyser ces algorithmes et fournir à la communauté scientifique une boite à outils facilitant leur utilisation.

Posons quelques éléments de décor. En machine learning comme en informatique en général, un programme est une fonction. Cela va d’un opérateur simple comme une somme, à une tache plus complexe comme la reconnaissance d’objets sur une image ou le traitement du langage naturel. « Entrez une image de chien ou de chat dans un ordinateur. On aimerait qu’il parvienne à dire s’il s’agit de l’un ou de l’autre. Pour trouver la bonne fonction, il faut la définir à l’aide de nombreux paramètres variables et donner des exemples de bonnes prédictions à l’ordinateur. Pour chaque valeur de ces paramètres, l’ordinateur est capable de déterminer un taux d’erreur de ces prédictions à l’aide des exemples fournis, et d’ajuster cette valeur de paramètre pour continuer de s’améliorer. », explique le jeune docteur issu du Centre de Mathématiques Appliquées (CMAP*) de l’École polytechnique.

Des algorithmes itératifs sont capables d’effectuer plus ou moins efficacement ce travail d’ajustement. Certains testeront des valeurs de la fonction d’erreur à minimiser en faisant des essais point par point et en s’appuyant sur une multitude d’entre eux. D’autres calculeront la dérivée de la fonction sur quelques points seulement. Ils détermineront une tendance à la baisse ou à la hausse des valeurs et iront chercher d’autres points dans la direction qui permettra de minimiser la fonction. Et ainsi de suite… « C’est le cas de l’algorithme Heavy Ball, élaboré au milieu des années 60 ».

Cet algorithme est très bien décrit et optimal pour les fonctions dites quadratiques (c’est à dire de type f(x)=ax²+bx+c). Toutefois, s’il semble adapté à de nombreuses autres fonctions, personne n’a jamais su prouver qu’il était alors idéal. « J’ai prouvé que ce n’était en effet pas démontrable car il existera toujours des fonctions pour lesquelles Heavy Ball ne sera pas optimal ou ne fonctionnera pas ».

D’une manière plus générale, Baptiste Goujaud a étudié une branche de l’optimisation qui consiste à automatiser les analyses d’algorithmes. Ceci afin de comparer leurs performances, définies par le nombre d’itérations nécessaires pour parvenir à un résultat satisfaisant. L’objectif final est de pouvoir « prescrire » le bon algorithme face à un problème, selon la fonction d’erreur qui le caractérise. « Il s’agissait de dire aux intéressés : vous êtes en présence de telle classe de fonctions, utilisez cet algorithme et vous parviendrez à une fonction plus simple et digeste pour l’ordinateur. L’outil que nous avons étudié permet d’accélérer la recherche de telle solution en la rendant aussi automatisée que possible ». Le jeune chercheur a donc développé une solution logicielle permettant aux utilisateurs de faire plus rapidement ces découvertes.

Aujourd’hui, Baptiste Goujaud se consacre à d’autres branches de l’optimisation du machine learning, à l’Inria. Il sera prochainement maitre de conférences à Télécom Sud Paris où il poursuivra l’exploration de ce sujet.

>> La thèse de Baptiste Goujaud

*CMAP: une unité mixte de recherche CNRS, Inria, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

Nikita Novikov, Département de Biologie, issu du Laboratoire de Biologie structurale de la Cellule (BIOC) à l’École polytechnique.

Le phénomène de migration cellulaire est impliqué dans de nombreux processus physiologiques et pathologiques – notamment le développement des métastases cancéreuses ou encore la cicatrisation – mais la mécanique moléculaire qui le régit n’est pas encore bien comprise. C’est là qu’intervient la thèse de Nikita Novikov.

La biologie cellulaire et moléculaire n’a pas fini de livrer ses secrets, notamment ceux de la migration cellulaire. Ce phénomène est impliqué dans de nombreux processus physiologiques et pathologiques – notamment le développement des métastases cancéreuses ou encore la cicatrisation – mais la mécanique moléculaire qui le régit n’est pas encore bien comprise. C’est là qu’intervient le travail de Nikita Novikov, récompensé par le prix de thèse 2025 du Département de Biologie de l’Institut Polytechnique de Paris.

Le jeune chercheur du Laboratoire de Biologie structurale de la Cellule (BIOC*) de l’École polytechnique, s’est intéressé à une protéine caractéristique d’une maladie génétique rare (Nance-Horan Syndrome) et déjà identifiée comme faisant partie de la mécanique moléculaire de migration cellulaire. « Mon travail a révélé dans un premier temps que la protéine NHSL3 intervient dans différents modes de migration cellulaire. Lorsque ce dernier est individuel, elle désoriente la cellule (impact négatif) qui ne sait plus dans quelle direction aller. En situation de migration collective en revanche, elle facilite la coordination entre les cellules leaders et suiveuses ».

Nikita Novikov s’est alors attelé à la compréhension des mécanismes spécifiques par lesquels NHSL3 exerce sa fonction. Il a étudié l’ensemble des formes que pouvaient prendre la protéine et a recherché avec quelles molécules ces dernières pourraient interagir dans la régulation de la migration cellulaire. Cette approche dite protéomique a montré qu’il existe plus de 340 partenaires potentiels de NHSL3. Les trier manuellement pour identifier les bons aurait pris des années. « J’ai donc fait appel à un outil de prédiction de structures protéiques basé sur l’intelligence artificielle (AlphaFold 2), amélioré par mes collègues du BIOC pour l’occasion ». En vérifiant les résultats d’AlphaFold2 à l’aide d’expérimentations de biologie cellulaire et moléculaire standards, Nikita Novikov a confirmé les prédictions de l’IA. « Les molécules identifiées sont bien celles qui régulent la mécanique de migration cellulaire, en conjonction avec NHSL3 ».

Par ce travail, Nikita Novikov met fin à une des difficultés majeures rencontrées en protéomique : l’analyse et le tri de grande quantité de données. « Ma thèse ouvre une nouvelle méthodologie de recherche en combinant de manière efficace les techniques computationnelles les plus récentes et la biologie cellulaire ». Elle servira de modèle dans la compréhension et la détermination des mécanismes moléculaires spécifiques qui régulent divers caractères cellulaires.

Aujourd’hui, le chercheur exerce toujours au sein du BIOC. « Il me reste encore à analyser de nombreuses données récoltées au cours de ma thèse. Je me pencherai ensuite sur l’étude détaillée de la mécanique moléculaire dans laquelle NHSL3 et ses partenaires sont impliqués ».

*BIOC : une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

Matthieu Vilatte, Département de Physique, issu du Centre de Physique Théorique (CPHT) de l’École polytechnique.

Au cours de sa thèse, Matthieu Vilatte a étudié la gravitation sous un angle quantique. Un exercice très théorique dans lequel le jeune chercheur s'est attelé à étudier la frontière des espace-temps afin d'y trouver des objets mathématiques capables de décrire les phénomènes à l’œuvre à l’intérieur, de manière quantique.

De l’Institut Polytechnique de Paris à l’université de Thessalonique en Grèce, Matthieu Vilatte a passé trois ans et demi à étudier la gravitation sous un angle quantique. « Des quatre forces fondamentales présentes dans la nature*, c’est la seule à ne pas avoir été intégrée aux trois autres qui forment le modèle standard de la physique des particules ». En effet, cette dernière décrit des objets évoluant dans un espace alors qu’ « avec la gravitation, il faut décrire l’espace lui-même et donc raisonner autrement », souligne le lauréat du prix de thèse 2025 du Département de Physique de L'institut Polytechnique de Paris.

Pour tenter de résoudre ce problème, Matthieu Vilatte, issu du Centre de Physique Théorique de l’École polytechnique (CPHT**), s’est intéressé à la théorie AdS/CFT*** (sujet parallèle à la théorie des cordes). Celle-ci démontre qu’étudier la frontière des espace-temps permet d’y trouver des objets mathématiques capables de décrire de manière quantique les phénomènes à l’œuvre à l’intérieur. « C’est le principe de l’holographie. L’information importante contenue dans l’espace-temps est projetée à sa frontière ».

Un détail a toutefois son importance : les scientifiques ont montré que cette holographie ne fonctionne que pour les espace-temps en forme de selle de cheval (courbure négative). Or, ceux-ci sont théoriques et n’existent pas dans l’univers. Le jeune chercheur s’est donc intéressé à un espace-temps plat de taille raisonnable - celui de notre galaxie – dont le type physique à sa frontière est connue, quoi qu’intrigant. « Cette physique, dite Carrollienne, permet, grâce à sa géométrie et aux champs qui y sont soumis, de décrire les phénomènes gravitationnels quantiques de l’intérieur plat ». Or, le modèle d’espace-temps plat étudié par Matthieu Vilatte inclut les interactions entre les trous noirs observables et, à sa frontière, la Terre. C’est là que les interféromètres LIGO et VIRGO ont révélé l’existence des ondes gravitationnelles. « Si deux trous noirs fusionnent quelque part dans la galaxie, les ondes générées distordront l’espace-temps et seront mesurées par LIGO et VIRGO. Ces données constituent l’unique source d’information nous permettant de tester notre modèle, c’est-à-dire de vérifier notre théorie sur la frontière ».

Au cours de sa thèse, le jeune docteur a donc vérifié son hypothèse en étudiant des théories satisfaisant à la géométrie de Carroll. Il a montré qu’à l’instar des démonstrations effectuées à la bordure des espace-temps à courbure négative, les équations régissant les objets à l’origine des ondes gravitationnelles sont reproductibles à partir d’un modèle défini uniquement sur la frontière des espace-temps plats. « C’est la première grande découverte en faveur de l’existence d’un principe holographique plat pour comprendre la gravitation de manière quantique dans l’univers réel ».

Aujourd’hui, Matthieu Vilatte poursuit ces travaux prometteurs en post doctorat à l’université de Mons en Belgique, en parallèle de recherches sur les trous noirs et la thermalisation. « J’espère à termes pouvoir m’appuyer sur la qualité de ma formation à IP Paris pour devenir enseignant-chercheur ».

>> La thèse de Matthieu Vilatte

*électromagnétique, nucléaire forte, nucléaire faible, gravitationnelle.

**CPHT: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

*** AdS – à courbure scalaire négative (Anti de Siter) / CFT – conformal field theory (théorie des champs conformes)

LIX: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

Institut Interdisciplinaire de l'innovation (i3): CNRS, École polytechnique, Mines Paris-PSL, Télécom Paris, Institut Polytechnique de Paris, 91120 Palaiseau, France

CREST: une unité mixte de recherche CNRS, École polytechnique, GENES, ENSAE Paris, Institut Polytechnique de Paris, 91120 Palaiseau, France

PMC: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

LadHyX: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

LTCI: un laboratoire de recherche Télécom Paris, Institut Polytechnique de Paris, 91120 Palaiseau, France

CMAP: une unité mixte de recherche CNRS, Inria, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

BIOC: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France

CPHT: une unité mixte de recherche CNRS, École polytechnique, Institut Polytechnique de Paris, 91120 Palaiseau, France